“La transformación de la inteligencia artificial (IA) es tan grande como cualquier cosa puede llegar a ser”, dijo el miércoles Sundar Pichai, presidente de Google y su holding Alphabet, en el escenario de la conferencia de desarrolladores Google I/O. La inteligencia artificial fue el tema principal de esta conferencia I/O, siete años después de que Pichai anunciara que Google era ahora la empresa “número uno en IA”. Pero la IA tiene riesgos, conocidos y desconocidos. Incluso si eso casi se pierde en el ajetreo y el bullicio que rodea a los nuevos anuncios, Google también ha cedido el escenario a una llamada de advertencia: James Manyika.

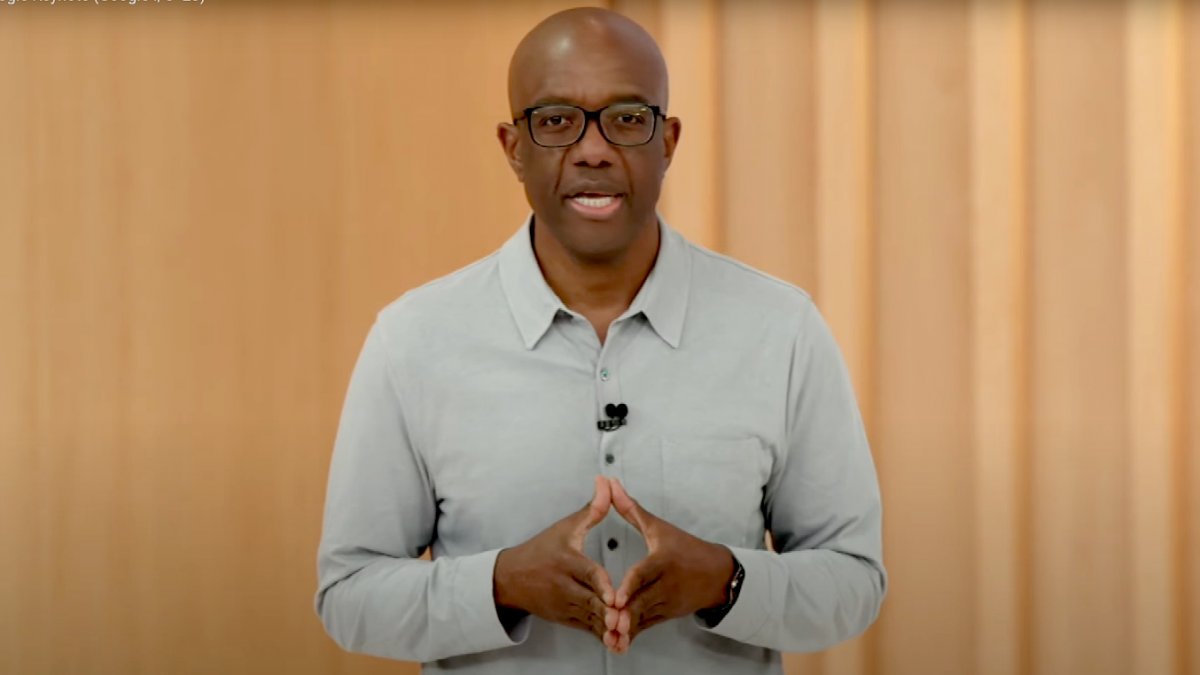

Intercalado con anuncios de Google, advirtió contra el lanzamiento de inteligencia artificial sin importar las consecuencias. Manica encabeza la nueva división de Tecnología y Sociedad de Google. “Si bien creo que es importante celebrar el asombroso progreso de la inteligencia artificial y el enorme potencial que tiene para las personas en todas partes, también debemos reconocer que es una tecnología en evolución que aún se está desarrollando y que aún queda mucho por hacer. hecho”, abrió el senegalés su discurso.

Google debe abordar la IA “con valentía y responsabilidad”, declaró poco antes su jefe Pichai en el mismo escenario en Mountain View. Esto es lo que señaló Manica: “Hay una tensión natural entre estas dos (polaridades)”, admitió, “Creemos que abrazar esa tensión no solo es posible, sino crucial. La única forma de ser audaz a largo plazo es ser responsable desde el principio.”

La IA hace avanzar muchas ciencias, pero la IA también corre el riesgo de exacerbar los desafíos sociales existentes, como los prejuicios injustos. Con el mayor desarrollo de la inteligencia artificial y los nuevos campos de aplicación, también surgirán nuevos riesgos.

La desinformación puede ser así de simple

La desinformación de Google es una preocupación particular. Surge la cuestión de la confianza, especialmente con la IA generativa. Como ejemplo llamativo, mostró un video corto del Traductor Universal de Google (Universal Translator, nombre tomado de Star Trek), en el que una señora habla primero en inglés (nativo) y luego repite lo mismo en español (producto de IA). Después de traducir el contenido en inglés al español, los sistemas de Google también registraron el estilo y el tono del habla, que luego se incorporaron a la salida de voz en español. Además, la IA generó movimientos de labios que coincidían con el texto en español. Al final, todo se unió en un video donde la dama canta en español con movimientos de labios a juego.

Manica informa que tal manipulación de alta calidad de los videos de los estudiantes tiene indicios tempranos de reducir las tasas de abandono escolar. Entonces, esta técnica podría ser “increíblemente útil, pero los malos pueden usarla para hacer deepfakes”.

Google está tomando precauciones

Sin embargo, la tarea de Manyika en Google I/O 2023 no fue solo resaltar los peligros de la IA y explicar por qué Google no siempre es el primero en presentar un nuevo servicio de IA, sino presentar al grupo como un proveedor responsable. El hombre se refirió a las siete reglas éticas para el desarrollo de inteligencia artificial creadas por Google en 2018. En consecuencia, la inteligencia artificial debe:

- beneficiar a la comunidad

- Evite crear o fomentar un sesgo injusto

- Estar orientado a la seguridad y probado

- Responsabilizarse de las personas

- Considerar la protección de datos y la seguridad de los datos en los principios fundamentales

- Cumplir con altos estándares de excelencia académica, y

- disponible para propósitos consistentes con estos principios.

En 2018, Pichai descartó la participación de Google en el desarrollo de algoritmos de inteligencia artificial para sistemas de armas militares. Lo mismo se aplica al desarrollo de tecnología apropiada que permita la vigilancia generalizada de personas o que viole los principios del derecho internacional y los derechos humanos.

Comprobación de imagen

Manica dijo el miércoles que los siete principios éticos de la IA “guían el desarrollo de nuestros productos y nos ayudan a evaluar cada aplicación de la IA”. Por ejemplo, el traductor global solo está disponible para usuarios seleccionados. Cualquier imagen y video generado por Google AI será etiquetado como un producto de AI por metadatos. A Google también le gustaría vencer a otros operadores de IA. El motor de búsqueda de Google debería marcar el contenido generado por IA como tal. Manica anunció más “innovaciones de marcas de agua” de IA, pero no pudo ser más específica.

En los próximos meses, Google agregará una herramienta a su motor de búsqueda que permitirá a los usuarios encontrar más información sobre las imágenes. Las imágenes encontradas a través de la búsqueda mostrarán cuándo Google vio por primera vez esta imagen o algo similar, y dónde encontró esa imagen, ya sea en sitios de noticias, sitios de redes sociales o sitios de verificación de hechos. Esta información puede ayudar a evaluar la credibilidad de la imagen.

No tienes que hacer todo lo que puedes hacer

Pero los principios de la IA también ayudarán a Google a decidir qué no hacer. “Hace años, fuimos la primera empresa en decidir no comercializar una interfaz genérica de programación de reconocimiento facial. Sentimos que no había suficientes medidas de seguridad”, señaló el vocero.

La compañía de datos ahora está trabajando para reducir los productos problemáticos de sus modelos de IA. Esto incluye expresamente la prueba contradictoria. El jefe de Google también habló sobre una interfaz de Google llamada Perspective: fue desarrollada para rastrear los comentarios tóxicos de los usuarios en Internet. Los académicos ahora han utilizado la perspectiva para desarrollar un criterio de evaluación para modelos grandes de lenguaje (LLM). Todos los LLM de interés, incluidos los de los competidores Anthropic y OpenAI, ahora utilizarán estos criterios para evaluar la toxicidad de sus modelos de lenguaje.

Sin embargo, Google no podrá superar los desafíos solo. Manica enfatizó que “construir una IA responsable debe ser un esfuerzo de colaboración” con investigadores, académicos de humanidades, expertos de la industria, gobiernos y personas comunes, pero también con creadores y editores. (…) Es un momento muy emocionante. Hay tanto que podemos lograr y tanto que debemos hacer bien. juntos “.

Contenido editorial recomendado

Con su consentimiento, se cargará aquí un video externo de YouTube (Google Ireland Limited).

Siempre sube un video de YouTube

James Manica, vicepresidente de tecnología y sociedad de Google

Discurso principal de Google I/O 2023

(s)

“Nerd de la cerveza en general. Ninja independiente de las redes sociales. Aficionado al alcohol incurable. Propenso a ataques de apatía”.

More Stories

PS5: Se acerca una nueva actualización beta, estas nuevas funciones te están esperando

Google está cambiando la forma en que maneja las cookies en Chrome

La nueva versión LZ4 comprime más rápido gracias al multithreading