En el futuro, Nvidia quiere ofrecer el doble de aceleradores de cálculo GPU que antes. Los mejores modelos ya no se lanzan cada dos años, sino anualmente. Las tarjetas gráficas para juegos también pueden beneficiarse de ciclos más cortos.

anuncio

Desde la generación Volta, Nvidia ha dividido el desarrollo entre tarjetas gráficas para juegos y aceleradores de GPU para servidores: la V100 exclusiva para servidores se lanzó en 2018, seguida de la A100 en 2020 y la H100 en 2022.

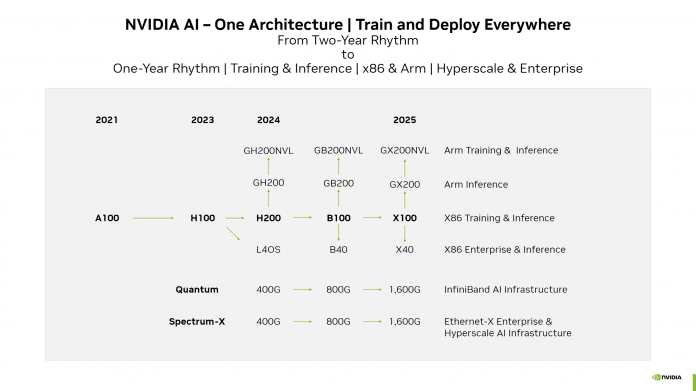

Como parte de un En una presentación para inversores, Nvidia publicó recientemente una hoja de ruta para la GPU.t, que indica el nuevo ritmo anual. La generación Blackwell surgirá el próximo año, encabezada por el B100. El cambio con arquitecturas de GPU adicionales comenzará en 2025. Nvidia llama al modelo superior “X100”, presumiblemente como un prefijo de marcador de posición.

Hoja de ruta de GPU de Nvidia para aceleradores informáticos. Tanto el A100 como el H100 se presentarán con un retraso de un año, tal vez porque la empresa ha podido enviar mayores cantidades desde entonces.

(Imagen: Nvidia)

Son posibles más modelos GeForce superiores

Además, Nvidia quiere llevar nuevas tarjetas gráficas a clientes empresariales con B40 y “X40” e implementar algoritmos de IA (heurísticas) completamente entrenados. Las ramas anteriores de esta categoría utilizan GPU que Nvidia también utiliza en sus mejores modelos GeForce. Por ejemplo, las nuevas L40S y GeForce RTX 4090 comparten la GPU AD102, y las A40 y GeForce RTX 3090 (Ti) comparten la GPU GA102.

Hasta ahora, estas variantes han utilizado GDDR en lugar de HBM RAM y también están diseñadas para cálculos de imágenes 3D. Si Nvidia mantiene esta división, es posible que en el futuro aparezcan nuevos modelos GeForce con más frecuencia.

Muchos otros modelos

Además del B100 y el “X100”, existen sus derivados habituales, como el GB200 y el “GX200”, que combinan un acelerador informático con un procesador ARM de desarrollo propio. Nvidia está promoviendo versiones de NVL de alta capacidad como líder en el entrenamiento de redes neuronales.

Una nueva versión del H100, llamada H200, acorta el tiempo de espera para Blackwell. Al igual que la placa GH200 anunciada, probablemente utilizará HBM3e en lugar de RAM HBM3, con una mayor tasa de transferencia y mayor capacidad.

Al mismo tiempo, la empresa está acelerando sus interconexiones y conmutadores, que conectan muchos servidores blade: en 2024, la velocidad de transferencia se duplicará a 800 Gbit/s, y en 2025 debería alcanzar 1,6 Tbit/s.

Los fondos para los cursos simplificados provienen principalmente de las ventas del A100 y H100. Las empresas literalmente están quitando de las manos de Nvidia los aceleradores de GPU para el entrenamiento de IA. Las ventas trimestrales de Nvidia con estas GPU aumentaron recientemente a más de 10 mil millones de dólares y se espera que sigan aumentando, limitadas únicamente por las capacidades de fabricación y empaquetado del fabricante de chips TSMC.

(MMA)

“Analista exasperantemente humilde. Experto en tocino. Orgulloso especialista en alimentos. Lector certificado. Escritor ávido. Defensor de los zombis. Solucionador de problemas incurables”.

More Stories

Coches eléctricos: los alemanes se declaran en huelga de compradores

Una bomba de la Segunda Guerra Mundial ha sido detonada con éxito en una fábrica de Tesla y se ha levantado la zona de exclusión

Día del Mercado de Valores miércoles 24 de julio de 2024